Las inteligencias artificiales generativas han permitido que ya no haga falta ser un experto para crear y manipular imágenes con resultados indistinguibles de la realidad. Esta nueva explosión creativa también tiene su reverso oscuro y permite que cualquiera pueda usar las fotos que has subido a tu red social favorita y manipularlas para acosarte o chantajearte. A pesar del aumento de este tipo de delitos, por el momento no hemos encontrado un sistema eficiente que evite esos usos maliciosos de la IA. Al menos hasta ahora. Investigadores del MIT acaban de presentar una nueva tecnología que, según dicen, es capaz de distorsionar estas manipulaciones y evitar que las hagan pasar por reales.

Las nuevas versiones de inteligencias artificiales generativas como Midjourney o Stable Diffusion ya son capaces de convertir texto en imágenes de un fotorrealismo extraordinario. También pueden modificar imágenes existentes y crear una nueva foto manipulada de tal calidad que hasta a los expertos les costaría distinguirlas de las reales.

Como explicamos en el episodio de Control Z: ‘El Fin de la Realidad’ (bajo estas líneas) tanto las fotos como los vídeos dejarán de ser en poco tiempo una prueba documental fiable de nuestras actividades. Esta tecnología se puede usar para el bien —algunos dicen que es el salto creativo más grande que ha dado la humanidad desde el siglo XIX— o para el mal, creando imágenes que sirvan para inculpar a un inocente de un crimen o para mostrar situaciones inventadas con las que acosar a adolescentes en el instituto.

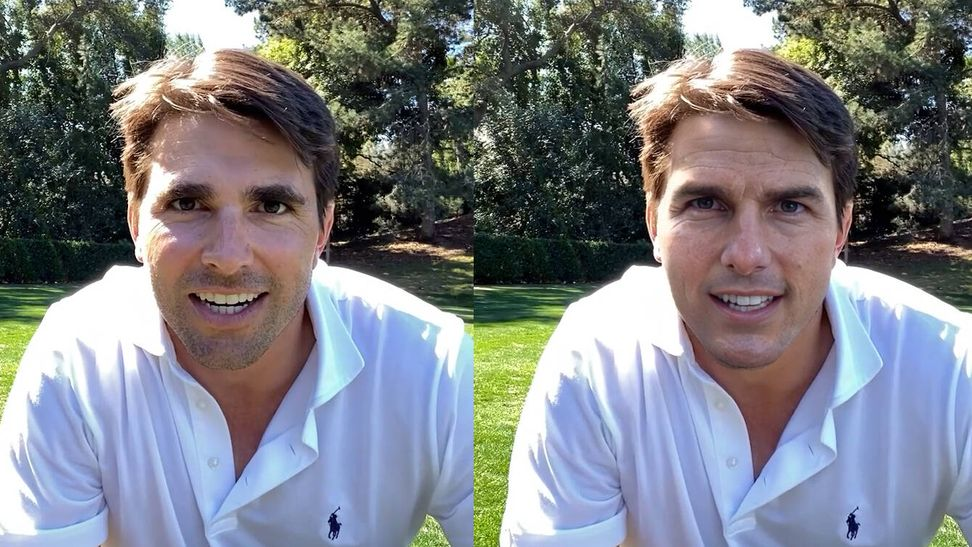

La segunda técnica se denomina ataque de difusión y los investigadores aseguran que es mucho más compleja. El ataque de difusión altera la forma en que los modelos de IA generan las imágenes, introduciendo señales ocultas que modifican completamente la forma en la que son procesadas. Volviendo a la imagen de Trevor Noah, el equipo consiguió manipular a la inteligencia artificial para que ignorara sus indicaciones de texto y generara una imagen gris que es claramente artificial.

«El progreso de la IA al que estamos asistiendo es realmente impresionante, pero permite usos beneficiosos y maliciosos por igual», afirma Aleksander Madry, profesor del MIT e investigador principal del CSAIL, que también es autor del artículo. «Por tanto, es urgente que trabajemos para identificar y mitigar estos últimos. Veo PhotoGuard como nuestra pequeña contribución a ese importante esfuerzo».

Un buena solución, por ahora

Los investigadores reconocen que, a pesar de su eficiencia, el sistema tiene sus limitaciones. Por ahora solo funciona con eficacia con Stable Difussion y no protege a las fotos más antiguas que ya se han subido a internet. Sin embargo, es una técnica que puede complementar otras como la incorporación de marcas de agua invisibles en las imágenes, aunque según nos contaron los expertos en las entrevistas realizadas para Control Z, esas marcas de agua pueden ser también falsificadas por los criminales fácilmente.

Los investigadores piensan que lo más eficaz sería que las empresas tecnológicas lo añadieran automáticamente a las imágenes que sube la gente a sus plataformas. Y animan a los creadores de estos modelos generativos de imágenes y a todas las partes interesadas a colaborar activamente para que tecnologías como la suya sean realmente eficaces, al menos hasta que los delincuentes encuentren la manera de sortearlas.

«Un enfoque colaborativo en el que participen desarrolladores de modelos, plataformas de medios sociales y responsables políticos presenta una sólida defensa contra la manipulación no autorizada de imágenes. Trabajar en este problema acuciante es de vital importancia hoy en día», afirma Salman. «Y aunque me complace contribuir a esta solución, queda mucho trabajo por hacer para que esta protección sea práctica. Las empresas que desarrollan estos modelos necesitan invertir en la ingeniería de inmunizaciones sólidas contra las posibles amenazas que plantean estas herramientas de IA. A medida que nos adentramos en esta nueva era de modelos generativos, esforcémonos por conseguir potencial y protección a partes iguales.»